Gain new perspectives for faster progress directly to your inbox.

Pourquoi plus grand ne rime pas toujours avec meilleur en matière d'outils d'IA et d'applications spécialisées

Depuis son lancement en 2022, ChatGPT a redéfini le discours autour de l'IA. On l'a qualifié à la fois de miracle et de menace, en raison de ses promesses positives comme de révolutionner le travail et de revitaliser les villes, mais aussi de ses conséquences négatives, telles que le remplacement des humains dans leur travail. Ce grand modèle de langage (LLM) serait capable de pratiquement tout.

Quelle est la différence entre ChatGPT et GPT-3/GPT-4 ?

Il existe des différences importantes entre ChatGPT et les LLM eux-mêmes, désignés par l'acronyme GPT suivi d'un chiffre (par ex. GPT-3 ou GPT-4). On les confond souvent ou on les utilise de manière interchangeable, mais ChatGPT est l'application de chatbot qui possède l'interface « conviviale » qui s'exécute au-dessus des LLM plus complexes (GPT-3 ou GPT-4).

GPT-3 et GPT-4 sont des versions différentes d'une série de modèles de transformateurs génératifs pré-entraînés. Les transformateurs constituent un type de réseaux neuraux appelé modèle linguistique. Ces modèles peuvent apprendre à identifier des modèles et des contextes dans des données peu structurées, comme des mots dans des phrases. Les transformateurs sont particulièrement efficaces dans ce domaine. Mis en contexte, un modèle génératif peut générer une sortie arbitrairement longue à partir d'une invite. Les modèles GPT combinent ces deux types de modèle.

D'un autre côté, ChatGPT est l'application qui se situe au-dessus des LLM comme GPT-3 ou GPT-4. Il possède un module de mémoire qui lui permet de poursuivre des conversations antérieures et dispose de filtres, de classificateurs et autres, intégrés pour minimiser les réponses toxiques ou inappropriées.

Que faut-il pour construire un LLM ?

Les LLM sont impressionnants. GPT-3 compte 175 milliards de paramètres ou de valeurs que le modèle peut modifier indépendamment à mesure qu'il apprend. GPT-4, la dernière version de la série GPT publiée en 2023, est encore plus volumineux, avec 1 trillion de paramètres. Comme peut en témoigner quiconque les a utilisés, ces modèles possèdent des connaissances d'une ampleur incroyable et des aptitudes étonnamment efficaces à produire des informations cohérentes.

Toutefois, ces capacités entraînent littéralement un coût. La formation de ces modèles GPT toujours plus importants et le déploiement d'applications comme ChatGPT est une prouesse d'ingénierie considérable. On estime que la construction de GPT-3 a coûté 4,6 millions de dollars et que son fonctionnement dans le cloud coûte au moins 87 000 dollars par an. Le développement de GPT-4 a probablement coûté la somme effarante de 100 millions de dollars, voire plus.

Au-delà de ces chiffres se dressent les coûts énormes du matériel et des ressources nécessaires à son fonctionnement tout en faisant en sorte que ses centres de données soient constamment refroidis. Les centres de données peuvent utiliser des milliards de litres d'eau et la climatisation consomme de l'énergie et contribue aux émissions, le tout obligeant les entreprises à évaluer les coûts et les avantages de ces puissants outils. En raison de ces coûts initiaux et continus, le coût des LLM est déjà prohibitif pour la plupart des entreprises privées, des établissements d'enseignement et des organisations du secteur public et cela ne changera pas à mesure que les modèles deviendront plus volumineux et plus puissants.

Les limites des LLM

Grâce à des composants structurels spécifiques, les modèles de transformateurs capturent la relation entre différentes entrées et disposant d'une grande quantité d'échantillons de texte, les LLM sont devenus très habiles pour extraire les éléments sémantiques larges d'un texte et suivre les relations entre les éléments textuels. Les modèles génératifs comme GPT-3 ont franchi un pas de plus et appris à suivre ces relations entre questions et réponses. Les résultats sont souvent fascinants. On peut demander à ChatGPT un nombre entre 0 et 100 ou si le cholestérol est un stéroïde, et on obtiendra généralement une réponse correcte.

Dans le cas d'applications spécialisées telles que la recherche scientifique, les grands modèles de langage ont parfois du mal à aller au-delà de la sémantique large et à comprendre les informations nuancées et spécifiques. Comment cela s'explique-t-il ? Tout d'abord, les LLM ne sont pas à l'abri du problème « données inexactes, résultats erronés ». Par ailleurs, même avec des données de formation de grande qualité, les informations d'entraînement pertinentes peuvent être sous-représentées.

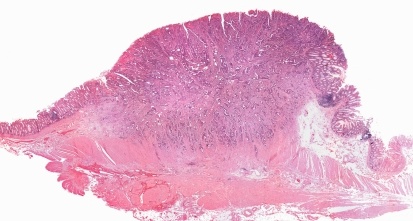

Les sujets larges et souvent décrits sont bien capturés par les LLM. En revanche, les sujets étroits et spécialisés sont presque toujours sous-représentés et seront inévitablement moins bien gérés. Par exemple, un grand modèle de langage peut atteindre le niveau d'abstraction adéquat et déterminer si un élément est une molécule stéroïde. Il pourrait même différencier deux molécules de stéroïdes appartenant à la même famille, mais il ne pourrait pas déterminer de manière cohérente si l'une est extrêmement toxique et l'autre pas. L'aptitude du grand modèle de langage à faire cette distinction dépend des données utilisées pour son entraînement et de l'identification et de la « mémorisation » d'informations correctes. Si elles ont été masquées dans un océan d'informations médiocres ou conflictuelles, le modèle n'a aucun moyen d'en extraire la réponse correcte.

Certains pourraient arguer que ce problème pourrait être résolu avec plus de données, des données plus propres et des modèles plus grands. Ils auraient peut-être raison, mais que se passe-t-il si on demande à un LLM génératif un nombre aléatoire entre 0 et 100 ? Peut-on être sûr que le nombre obtenu est vraiment aléatoire ? Pour répondre à cette question, nous devons aller au-delà de la sémantique lexicale et des faits mémorisés, au-delà des LLM et en direction des agents d'IA. Dans ce cas, l'agent construirait un élément de code exécutable en utilisant des procédures validées, le transmettrait à un autre processus qui l'exécuterait, puis traiterait le résultat et présenterait la réponse à l'utilisateur.

Les défis spécifiques aux données scientifiques

Comme le savent mes collègues de CAS, les données scientifiques peuvent être beaucoup plus complexes que le texte et la plupart des problèmes ne peuvent pas être exprimés en une ou deux questions.

Lorsque nous utilisons des outils gérés par l'IA dans la recherche scientifique, nous devons nous demander quel problème nous essayons de résoudre. De nombreux problèmes impliquent des séquences de langage ou faiblement structurées, de sorte que les modèles de langage conviennent parfaitement. Mais qu'en est-il des données tabulaires, des données catégoriques, des graphes de connaissances et des séries temporelles ? Ces formes de données sont nécessaires à la recherche scientifique, mais les LLM ne peuvent pas toujours les exploiter. Cela signifie que les LLM à eux seuls ne peuvent pas fournir le niveau de spécificité nécessaire à une application telle que la recherche moléculaire. En fait, de même qu'un orchestre a besoin de nombreux instruments pour produire un son cohérent, la science a besoin de multiples outils dans sa boîte à outils d'IA pour produire des résultats cohérents.

Une approche des systèmes en termes de profondeur autant que d'ampleur

Si les LLM seuls ne sont pas adaptés à la recherche scientifique, que peut-on utiliser ? La réponse est une approche par systèmes qui utilise de multiples types de modèles pour générer des sorties spécialisées. En superposant des modèles de langage et des réseaux neuraux avec des outils traditionnels d'apprentissage machine, des graphes de connaissances, la chimio-informatique et la bio-informatique, ainsi que des méthodes statistiques telles que TF-IDF, les chercheurs peuvent inclure des informations nuancées et approfondies dans leurs programmes gérés par l'IA.

Ces outils peuvent fournir les résultats spécifiques nécessaires à des tâches telles que le développement de nouvelles molécules de médicaments ou l'invention d'un nouveau composé. Les graphes de connaissances sont particulièrement précieux, car ils agissent comme une réalité de terrain, en connectant de manière fiable des entités connues : une molécule, une réaction, un article publié, un concept contrôlé, etc. Un cas d'utilisation idéal concerne l'exploitation d'un réseau neural profond capable de dire : « Ceci est un certain type de substance » et d'un graphe de connaissances qui validera l'exactitude de cette affirmation. C'est ainsi que l'on peut obtenir des faits fiables nécessaires à la recherche scientifique.

Ce type d'approche par systèmes est essentiellement une fonction de vérification des faits qui permet d'améliorer la fiabilité des données et qui s'avère efficace dans les applications spécialisées. Par exemple, Nvidia a récemment publié Prismer, un modèle vision-langage conçu pour répondre à des questions sur des images ou produire des légendes pour ces mêmes images. Ce modèle utilise une approche par « mélange d'experts » qui forme de multiples sous-modèles plus petits. La profondeur des connaissances de ce modèle a fourni des résultats de qualité sans entraînement massif : elle a permis de mettre en correspondance la performance de modèles formés avec 10 à 20 fois plus de données.

Google travaille également sur une approche similaire, où la connaissance est extraite d'un modèle de langage « enseignant » polyvalent vers des modèles « étudiants » plus petits. Les modèles étudiants présentent de meilleures informations que le modèle plus grand en raison de leurs connaissances plus approfondies : un modèle étudiant formé sur 770 millions de paramètres a surclassé son enseignant disposant de 540 milliards de paramètres sur une tâche de raisonnement spécialisée. Même si l'entraînement du petit modèle est plus long, les gains d'efficacité continus sont très utiles, car il est à la fois moins cher et plus rapide à exécuter.

Améliorer la recherche scientifique

Un autre exemple d'approche par systèmes efficace est le PaSE, ou moteur de similitude des brevets, développé par mes collègues et moi-même chez CAS, qui alimente des fonctionnalités uniques de CAS STNext et de CAS SciFinder. Nous avons construit ce modèle dans le cadre de notre collaboration avec l'Institut national de la propriété intellectuelle (INPI) brésilien, l'office national des brevets du Brésil. Il a été conçu pour traiter d'énormes quantités d'informations en quelques minutes seulement, afin de permettre aux chercheurs de s'attaquer aux retards persistants dans l'examen des brevets.

Cette solution inclut un modèle de langage qui utilise les mêmes techniques essentielles d'apprentissage machine que la famille GPT, mais elle se superpose sur des types supplémentaires d'apprentissage, y compris des graphes de connaissances, de la chimio-informatique et des méthodes traditionnelles de récupération des informations. En formant le modèle à la science mondiale, par exemple au texte intégral de brevets et de revues figurant dans CAS Collection de contenusTM, le moteur PaSE a atteint la profondeur et l'ampleur nécessaires pour identifier les « techniques antérieures » 50 % plus rapidement qu'en utilisant une recherche manuelle.

Pour les offices des brevets, il est extrêmement difficile de prouver que quelque chose n'existe pas. Pensez à l'adage : « l'absence de preuve n'est pas la preuve de l'absence ». Nos scientifiques des données ont entraîné et optimisé le modèle en lien avec des chercheurs experts en brevets, l'équipe de l'INPI brésilienne et une combinaison unique d'outils d'IA qui a identifié les techniques antérieures avec 40 % de recherche manuelle en moins. Grâce à cette performance et à la réduction du retard dans l'octroi des brevets, il a obtenu le prix Stu Kaback Business Impact Award décerné par le Patent Information Users Group en 2021.

Le parcours futur des grands modèles de langage dans la science

Cette expérience prouve que les LLM continueront à jouer un rôle majeur dans la recherche scientifique à l'avenir, mais que contrairement aux croyances populaires, cet outil n'est pas une panacée répondant à chaque problème ou chaque question.

J'aime comparer ces modèles au rangement d'une pièce désordonnée dans votre maison, par exemple un placard ou un grenier. Des personnes différentes peuvent organiser les objets présents dans ces pièces de différentes manières. Une personne pourrait tout ranger par couleur, alors qu'une autre réunira tous les objets de valeur et qu'une troisième les classera par fonction. Aucune de ces approches n'est mauvaise, mais il ne s'agit peut-être pas du type d'organisation que vous appréciez ou dont vous avez besoin. Il s'agit essentiellement du problème des LLM, qui sont capables d'organiser l'information d'une certaine manière, qui n'est pas celle dont un scientifique ou un chercheur a besoin.

Pour les applications spécialisées dans lesquelles l'utilisateur a besoin d'un certain résultat, par exemple les séquences protéiques, les informations sur les brevets ou les structures chimiques, les modèles alimentés par l'IA doivent être entraînés pour organiser et traiter l'information de manière spécifique. Ils doivent être en mesure d'organiser les données, les résultats et les variables comme le souhaitent leurs utilisateurs pour un entraînement et des prédictions optimum.

Pour en savoir plus sur l'impact de ces données, leur représentation et les modèles qui améliorent les prédictions scientifiques, consultez nos études de cas avec CAS Services personnalisés. Vous aimeriez en savoir plus sur le paysage émergent de l'IA et de la chimie ? Lisez notre dernier livre blanc sur les opportunités que l'IA peut offrir à la chimie ou explorez nos ressources sur la manière dont l'IA peut améliorer la productivité des offices de brevets du monde entier.