Gain new perspectives for faster progress directly to your inbox.

为什么人工智能工具和专业应用程序并不总是越大越好?

自2022年发布以来,ChatGPT重新定义了人工智能的对话方式。 从积极的角度看,ChatGPT是一个奇迹,有望彻底改变工作方式、提升城市活力;但从消极的角度看,ChatGPT又会取代人类工作岗位。据称,该大语言模型 (LLM) 几乎无所不能。

ChatGPT与GPT-3/GPT-4有什么区别?

ChatGPT和LLMs (命名为GPT+数字,例如GPT-3,GPT-4) 之间存在显著不同。 二者经常被混淆或互换使用,但ChatGPT是在更复杂的LLMs (例如,GPT-3或GPT-4) 上运行的聊天机器人应用程序,特点是界面“易于使用”。

PT-3和GPT-4是一系列生成式预训练Transformer模型的不同版本。 Transformer是一种神经网络,被称为语言模型。 这些模型可以学习识别松散结构数据的模式和上下文,如句子中的单词, 且Transformer尤其擅长这一点。 给定上下文时,生成模型可以根据提示生成任意长度的输出信息, 而GPT模型则结合了这两种模型。

另一方面,ChatGPT是在GPT-3或GPT-4等LLMs基础上建立的应用程序。 ChatGPT配有一个存储模块,可以继续先前的会话,还有过滤器、分类器以及更多的内置功能,可以最大程度地避免有害或不恰当的回答。

构建大语言模型需要什么?

LLM 令人惊叹。 GPT-3有1,750亿个参数,该模型可以随着学习而自行更改这些数值。 GPT-4是2023年推出的GPT系列最新版本,拥有1万亿个参数。 使用过这些模型的人都可以证明,它们拥有令人难以置信的广博知识和惊人的连贯对话的能力。

然而,这些令人惊叹的能力代价也同样不菲。 训练规模更大的GPT模型和配置应用程序 (如ChatGPT) 是一项巨大的工程。 据估计,GPT-3的构建成本为460万美元,云端运行成本每年至少87,000美元。 GPT-4的研发成本甚至可能超过令人瞠目的1亿美元。

在这些数字之上是硬件和资源的高昂成本,主要用于保持GPT-4运行,同时确保其数据中心低温运行。 数据中心用水量达数十亿加仑,空调系统要消耗能源并排放温室气体,因此企业需要对这些强大工具的成本和收益进行评估。 鉴于这些前期和后续的成本,对于大多数私营公司、学术界和公共部门组织来说,LLMs已经昂贵到了令人望而却步的地步,而随着模型的扩容和功能的增强,这种情况还将持续下去。

大语言模型的局限性

得益于特定的结构组件,Transformer模型可采集不同输入内容之间的关系,并且由于有大量示例文本,现代LLMs已经非常擅长提取一段文本的广泛语义并跟踪文本元素之间的关系。 像GPT-3这样的生成模型则更进一步,学会了在问题和答案之间追踪这些关系, 结果往往令人信服。 我们可以向ChatGPT询问0到100之间的数字,或者询问胆固醇是否是类固醇,基本上都会得到正确的答案。

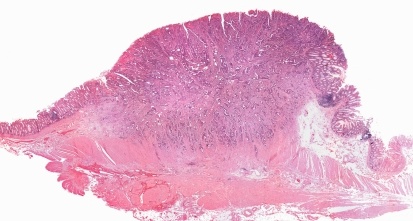

然而,对于科学研究等专业应用,大语言模型可能很难跳出宽泛的语义来理解细微差别的特定信息。 为什么会这样呢? 首先,LLMs无法避免“垃圾输入/垃圾输出”问题的影响。 其次,即使有高质量的训练数据,相关训练信息也可能缺乏代表性。

LLMs能够很好地处理宽泛和常见的话题,但小范围和专业性话题几乎总是缺乏代表性,注定无法很好地予以处理。 例如,大语言模型可以正确处理抽象层面问题,确定某些物质是否是类固醇分子。 它甚至可以识别同一家族的两种类固醇分子,但无法始终识别哪种有剧毒哪种没有。 大语言模型这种区分能力取决于训练所用的数据,以及是否识别并“记住”了正确的信息。 如果这些信息隐藏在海量错误或相互矛盾的信息中,模型就不可能给出正确答案。

有些人可能会反驳说,更多、更干净的数据以及更大的模型可以解决这个问题。 也许他们是对的,但如果我们要求生成式大语言模型在0到100之间选择一个随机数呢? 我们能确定给出的数字确实是随机的吗? 为了回答这个问题,我们需要超越词汇语义和存储事实、超越LLMs并转向人工智能代理。 在这种情况下,人工智能代理将利用经过验证的程序构造成一段可执行代码,然后将代码传递给另一个进程运行并处理结果,将答案呈现给用户。

科学数据的特定挑战

科学数据可能比文本复杂得多,而且大多数问题不能用一两句话说清楚。

当使用人工智能驱动的工具进行科学研究时,我们必须扪心自问:我们试图解决什么问题? 许多问题涉及语言或结构松散的序列,所以语言模型是一个非常恰当的选择。 那么表格数据、分类数据、知识图谱和时间序列呢? 尽管这些形式的数据是科学研究所必需的,但 LLM 无法始终对其加以利用。 这就意味着,单靠 LLM 无法提供分子研究等应用所需的特定程度。 相反,就像管弦乐队需要众多乐器才能发出协调一致的声音,科学也需要人工智能工具箱中的多种工具才能产生一致的结果。

兼顾深度和广度的系统方法

如果单靠LLMs不适合科学研究,那什么才适合呢? 答案就是采用系统方法,即利用多种模型来生成专业输出信息。 通过将语言模型和神经网络与传统的机器学习工具、知识图谱、化学信息学和生物信息学以及 TF-IDF 等统计方法分层,研究人员可以在其人工智能驱动的程序中包含深层次的细微信息。

这些工具可以为开发新药物分子或发明新化合物等任务提供所需的特定结果。 这些工具可以为开发新药物分子或发明新化合物等任务提供所需的特定结果。知识图谱的价值尤为突出,因为它是将分子、反应、发表的文章、概念词等标引信息进行关联的可靠依据。理想的用例是利用一个深度神经网络,它可以指出“这是某种物质”,同时提供知识图谱以验证准确性。 这就是我们获取科学研究所需可靠事实的方法。

这种系统方法本质上是一种事实核查或验证功能,用于提高数据可靠性。 例如,Nvidia 最近发布了一款视觉语言模型 Prismer,旨在回答有关图像的问题或为图像提供说明。 该模型采用“专家混合”方法,可训练多个较小的子模型。 该模型的知识深度无需大量训练即可提供高质量的结果,其性能可媲美用 10 到 20 倍数据训练出来的模型。

谷歌也在研究类似的方法,从通用的“教师”语言模型中提取知识到较小的“学生”模型中。 由于学生模型具有更深层次的知识,因此能够比大模型提供更好的信息。在一项专门的推理任务中,一个经过 7.7 亿个参数训练的学生模型的表现要优于使用 5400 亿个参数的教师模型。 虽然较小的模型需要更长的训练时间,但由于其运行成本更低、速度更快,因此持续效率的提升很有价值。

改善科学研究

另一个成功的系统方法是 PaSE,即专利相似性引擎,该引擎由我和我的 CAS 同事们开发而成,为 CAS STNext 和 CAS SciFinder 的独特功能提供支持。 作为与巴西国家工业产权局 (INPI) 合作的一部分,我们建立了该模型。 其设计目的是在短短几分钟内处理海量信息,以便研究人员解决长期积压的专利问题。

该解决方案包括一个语言模型,该模型使用了与 GPT 系列相同的关键机器学习技术,但还增加了其他学习类型,包括知识图谱、化学信息学和传统的信息检索统计方法。 通过对全球科学(如 CAS 内容合集TM 中的专利和期刊全文)进行模型训练,PaSE 达到了查找“现有技术”所需的深度和广度,比人工检索快 50%。

对于专利局而言,证明不存在的事物极具挑战性。 想想这句谚语:“缺乏证据并不表明证据不存在”。我们的数据科学家与专利检索专业人员、巴西 INPI 团队以及人工智能工具的独特组合一起合作,对模型进行了训练和优化,结果发现现有技术的人工检索减少了 40%。 由于这一表现和专利积压的减少,该模型于 2021 年被专利信息用户组授予 Stu Kaback 商业影响力奖。

科学领域大语言模型的前景

这一经验表明,LLMs将继续在未来的科学研究中发挥重要作用,但与普遍看法相反,这个工具并不是解决所有问题的灵丹妙药。

我喜欢把这些模型想象成整理家中凌乱的房间,比如壁橱或阁楼。 不同的人可能会以不同的方式整理这些房间里的物品。 有的人可能会按照颜色来整理所有物品,而有的人则可能会把所有贵重物品放在一起,还有人可能会按照功能来整理。 这些方法都没有错,但它们可能并不是你想要或需要的整理方式。 这是LLMs的根本问题,大语言模型可能会以某种方式整理信息,但这不是科学家或研究人员需要的方式。

对于用户需要特定结果 (如蛋白质序列、专利信息或化学结构) 的专业应用,人工智能驱动的模型必须经过训练,以特定的方式组织和处理信息。 它们需要以用户希望的方式整理数据、结果和变量,从而实现最佳的训练和预测效果。

要进一步了解这些数据的影响、其表现形式以及正在改善科学预测的模型,请查看我们与 CAS 定制服务合作的案例研究。 想了解有关人工智能和化学新兴领域的更多信息? 欢迎阅读我们的最新白皮书,了解人工智能为化学带来的种种机遇,或探索我们的相关资源,认识人工智能如何提高全球各地专利局的工作效率。